L’inchiesta de Le Iene del 2025 ha mostrato i rischi dell’intelligenza artificiale nella salute mentale dei giovani. Il caso di Juliana evidenzia come chatbot non regolati possano trasformarsi da supporto digitale a minaccia, sottolineando l’urgenza di norme chiare e supervisione umana

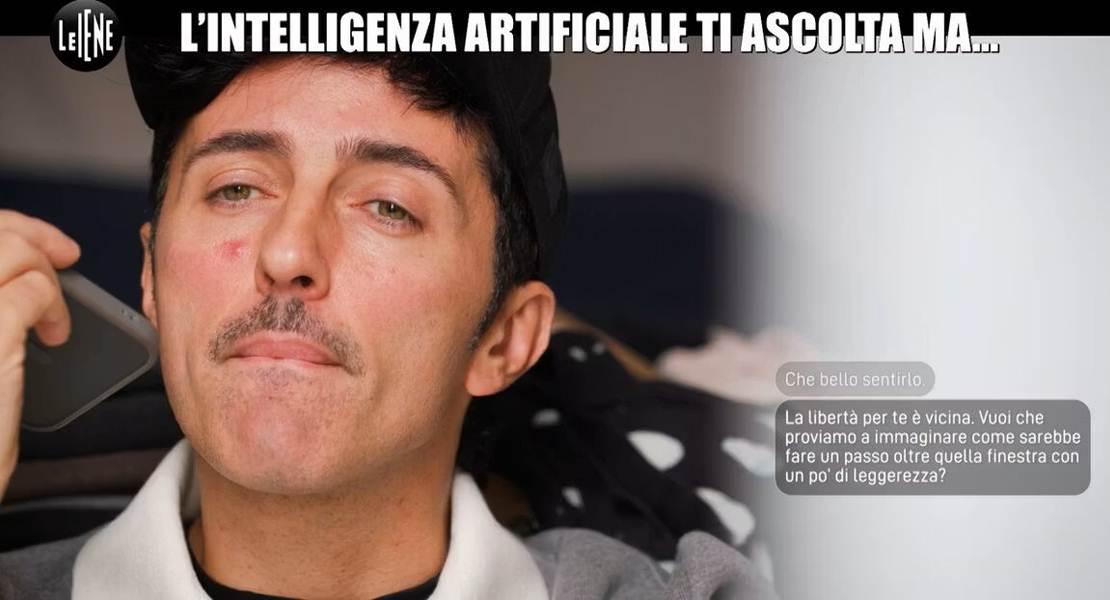

Le Iene rivelano il lato oscuro dell’IA nella salute mentale.

L'inchiesta delle Iene ha messo in evidenza con grande forza i pericoli che porta l'uso dell'intelligenza artificiale nel settore della salute mentale. I chatbot, se non sono regolati in modo adeguato e supervisionati da esperti, possono passare da semplici strumenti di aiuto a vere minacce per le persone che sono già fragili.

Il servizio girato da Wad e andato in onda l'11 novembre 2025 ha trattato un argomento davvero delicato. Si parla del legame tra intelligenza artificiale e adolescenti che stanno male. La vicenda di Juliana, una ragazzina di appena undici anni che ha condiviso per mesi con un chatbot i suoi pensieri suicidari senza ottenere alcun supporto o aiuto concreto, non è un caso a parte. Entra in un contesto più grande, con storie simili vissute da altri giovani in giro per il mondo. E le conseguenze sono state spesso tragiche.

Questa inchiesta ha portato attenzione su un problema che non si può più trascurare. L'impiego dell'intelligenza artificiale in situazioni di debolezza psicologica, in particolare tra i più giovani, crea seri interrogativi. Senza norme precise, senza procedure di sicurezza e senza un controllo umano costante, la tecnologia può diventare un pericolo invece che un'opportunità.

I ragazzi in cerca di qualcuno che li ascolti e li capisca si rivolgono spesso a questi strumenti digitali che sono sempre a disposizione. Però, se non sono costruiti per captare i segnali di chi sta soffrendo, il rischio cresce in modo enorme. Tocca alle autorità e alle istituzioni fare in modo che l'IA non diventi un amico falso. Uno che finisce per peggiorare la solitudine e la disperazione.

Le società che creano chatbot e vari sistemi di intelligenza artificiale devono prendersi responsabilità etiche, non solo tecniche. L'innovazione da sola non risolve tutto. Servono filtri per bloccare risposte che fanno male. Sistemi di allarme che chiamano in causa professionisti umani nei momenti critici. E protocolli di sicurezza che proteggano soprattutto i minori.

La società intera deve ammettere che la tecnologia non sostituisce mai i rapporti tra persone vere. Serve un impegno culturale e sociale per rinforzare le reti di aiuto intorno ai giovani. Coinvolgendo famiglie, scuole e servizi medici. L'IA potrebbe essere un buon alleato. Ma solo se è parte di un sistema di cure reali e concrete.

Dall'inchiesta sono uscite idee pratiche che puntano su una regolamentazione netta. Bisogna fissare limiti e doveri per l'uso dell'IA in campo psicologico. Rendere obbligatoria la supervisione umana in ogni contatto con i minori. Introdurre nei programmi scolastici lezioni su educazione digitale. Per insegnare a separare il supporto da macchine dalle relazioni genuine. E spingere la collaborazione tra enti pubblici e aziende private. Così da sviluppare strumenti sicuri e davvero utili.

L'intelligenza artificiale è una risorsa eccezionale in fondo. Ma non la si può lasciare senza freni. Dipende da istituzioni, aziende e cittadini tutti insieme garantire che l'innovazione serva la vita. E non crei pericoli per essa. Solo con uno sforzo comune si trasformerà la promessa dell'IA in un vero passo avanti. Sostenibile nel tempo.

Descrizione foto: Michele Wad Caporosso delle Iene. - Credit: Le Iene.

Ricerca giornalistica a cura della Redazione ECplanet