Le interfacce cervello-computer evolvono: ora decodificano pensieri e linguaggio grazie all’IA, offrendo nuove soluzioni per chi vive con la paralisi

Anatomia di una mente inquieta: viaggio nella complessità interiore.

Da anni le persone con paralisi utilizzano le interfacce cervello-computer per trasformare i segnali neurali in azioni semplicemente pensando a ciò che desiderano fare: scrivere parole, muovere arti robotici, generare voce. Ma una nuova ricerca pubblicata sulla rivista Cell (1) rivela che queste tecnologie potrebbero andare oltre, riuscendo a decodificare non solo il linguaggio intenzionale, ma anche i pensieri più profondi. In un certo senso.

Secondo i dottor Daniel Rubin (2), neurologo al Mass General e docente alla Harvard Medical School, si tratta di un passo fondamentale per chi ha difficoltà comunicative.

«La comunicazione è una parte essenziale di ciò che siamo come esseri umani», afferma Daniel Rubin. «Ogni modo in cui possiamo contribuire a ripristinarla è un modo per migliorare la qualità della vita».

Interfacce cervello-computer: ora decifrano anche i muscoli del linguaggio

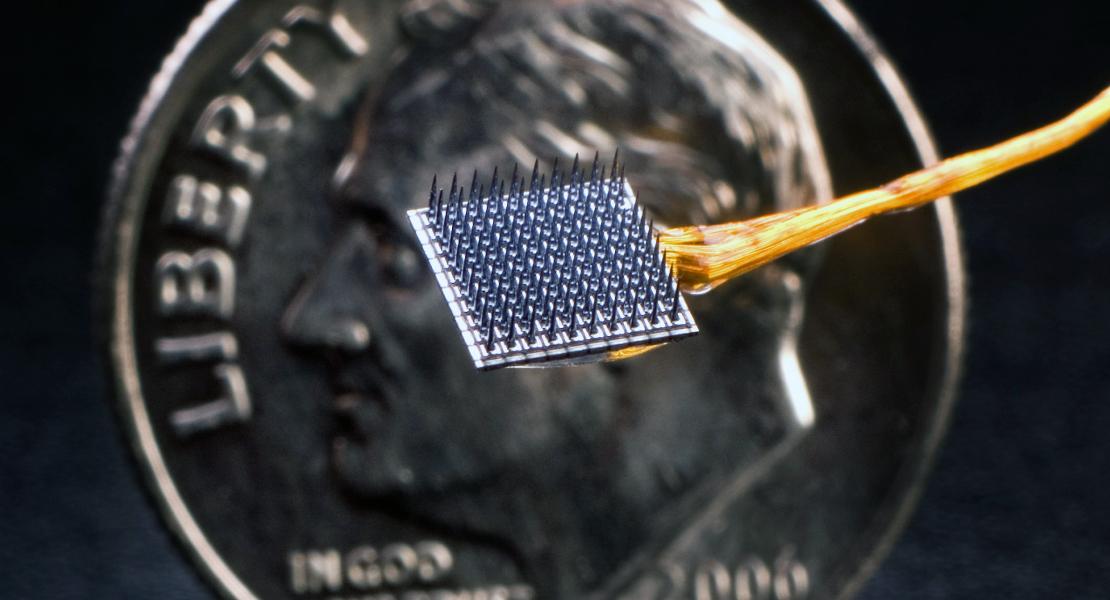

Lo studio si basa su decenni di ricerca del progetto BrainGate, un trial clinico multi-istituzionale di lunga durata. I primi esperimenti hanno permesso a persone con paralisi di svolgere diverse attività - scrivere lettere, muovere il cursore del computer, controllare un braccio meccanico - grazie a un’interfaccia cervello-computer (BCI) impiantata. I partecipanti immaginavano di muovere le mani in varie direzioni, mentre minuscoli sensori nella corteccia motoria decodificavano le intenzioni.

Negli ultimi anni, i ricercatori si sono chiesti se fosse possibile decodificare non solo i movimenti di mani e braccia, ma anche quelli dei muscoli coinvolti nel linguaggio - come viso, bocca, mascella e lingua.

La risposta è sì, ma solo grazie ai progressi dell’intelligenza artificiale.

«Decodificare il linguaggio è un problema computazionale molto diverso rispetto ai movimenti delle mani», ha spiegato il dottor Daniel Rubin, autore dello studio.

Per semplificare la sfida, i partecipanti hanno provato a pronunciare frasi predefinite. Array di elettrodi impiantati nella corteccia motoria hanno rilevato segnali neurali corrispondenti a 39 fonemi della lingua inglese, ovvero i suoni base del linguaggio. I modelli di machine learning hanno poi ricostruito i suoni in parole e frasi probabili.

«Il sistema lavora in modo probabilistico», ha spiegato il dottor Ziv Williams (3), neurochirurgo al Massachusetts General Hospital e professore associato alla Harvard Medical School. «Ad esempio, se si registrano i neuroni e si rilevano i suoni ‘D’ e ‘G’, è probabile che la persona stia cercando di dire ‘dog’».

Questa tecnologia rappresenta un passo rivoluzionario per la comunicazione assistita, combinando neuroscienze e intelligenza artificiale per dare voce ai pensieri.

L’intelligenza artificiale ora prova a leggere i pensieri interiori

Dopo aver dimostrato che gli algoritmi possono decodificare il linguaggio intenzionale, i ricercatori - guidati dal team BrainGate della Stanford University, insieme a Ziv Williams, Daniel Rubin e Leigh Hochberg (4) di Harvard/MGH - hanno rivolto l’attenzione al linguaggio interiore. Studi precedenti avevano già suggerito che ripetere mentalmente le parole attiva le stesse aree della corteccia motoria coinvolte nel parlare, anche se con segnali più deboli.

In uno degli esperimenti condotti per esplorare la decodifica del linguaggio interiore, ai partecipanti è stato chiesto di osservare una griglia di forme colorate - cerchi verdi, rettangoli verdi, cerchi rosa e rettangoli rosa. L’ipotesi era che, contando solo i rettangoli rosa, i partecipanti avrebbero usato il linguaggio interiore per scandire mentalmente i numeri. Dopo numerose prove, il decoder ha imparato a riconoscere le parole numeriche dai conteggi non pronunciati.

Ma il sistema ha mostrato i suoi limiti quando i ricercatori hanno cercato di decodificare pensieri interiori non strutturati. Quando ai partecipanti venivano poste domande autobiografiche aperte - come “Pensa a una vacanza memorabile” - i decoder producevano perlopiù rumore.

Per il dottor Daniel Rubin, neurologo di Harvard, la ricerca tocca le radici stesse del pensiero e i limiti di ciò che possiamo comprendere osservando il cervello altrui.

«Quando penso, sento la mia voce interiore che parla. Ho sempre un monologo interno», spiega Rubin. «Ma non è un’esperienza universale».

Molte persone non sentono parole quando pensano. Chi comunica principalmente con la lingua dei segni, ad esempio, può vivere il pensiero come visualizzazione di movimenti delle mani.

Secondo Rubin, siamo solo all’inizio di una nuova frontiera della neuroscienza:

«Stiamo iniziando a costruire gli strumenti per riflettere su questo. L’idea che la rappresentazione del linguaggio parlato sia distinta da quella del linguaggio in sé è rivoluzionaria».

Impianti cerebrali di nuova generazione promettono una svolta per le persone con paralisi

Gli impianti cerebrali di nuova generazione potrebbero contenere fino a dieci volte più elettrodi nello stesso spazio, ampliando enormemente la quantità di segnali neurali che i ricercatori possono decodificare. Lo afferma Daniel Rubin, neurologo di Harvard, convinto che questa evoluzione farà una grande differenza per gli utenti del futuro.

«Essendo una ricerca sperimentale, non possiamo garantire che tutto funzioni perfettamente», spiega Rubin. «I partecipanti lo sanno, e dicono: ‘Sarebbe fantastico se potessi davvero usare questa tecnologia e mi fosse utile.’ Ma si impegnano soprattutto per aiutare chi, in futuro, vivrà con la paralisi e potrà avere una vita migliore».

E per alcuni, il cambiamento è già realtà: due dei quattro partecipanti descritti nello studio utilizzano l’interfaccia cervello-computer (BCI) come principale strumento di comunicazione.

Riferimenti:

(1) Inner speech in motor cortex and implications for speech neuroprostheses

(2) Daniel Rubin

(3) Ziv Williams

(4) Leigh Hochberg

Descrizione foto: Immagine di un array di elettrodi come quelli impiantati nel cervello dei partecipanti allo studio. - Credit: Photo courtesy of Daniel Rubin.

Autore traduzione riassuntiva e adattamento linguistico: Edoardo Capuano / Articolo originale: A deeper read of unquiet minds