Un robot impara il lip sync realistico grazie all’IA, superando l’Uncanny Valley con movimenti facciali naturali. Una svolta nella robotica umanoide che rivoluziona comunicazione, espressività e interazione uomo‑macchina

Lip Sync robotico: la tecnologia che cambierà l’interazione uomo‑macchina.

Quasi metà della nostra attenzione durante una conversazione faccia a faccia è rivolta al movimento delle labbra. Eppure, i robot faticano ancora a muovere correttamente le loro labbra. Anche gli umanoidi più avanzati fanno poco più che gesti da “muppet” con la bocca – ammesso che abbiano un volto.

Noi esseri umani attribuiamo un’importanza enorme ai gesti facciali in generale, e al movimento delle labbra in particolare. Mentre possiamo perdonare un modo buffo di camminare o un movimento goffo della mano, rimaniamo inflessibili anche di fronte alla più lieve malgestualità del viso. Questo standard elevatissimo è noto come “Uncanny Valley”. I robot spesso sembrano privi di vita, persino inquietanti, perché le loro labbra non si muovono. Ma questo sta per cambiare.

Un team della Columbia Engineering ha annunciato di aver creato un robot che, per la prima volta, è in grado di apprendere i movimenti delle labbra per compiti come parlare e cantare. In un nuovo studio pubblicato su Science Robotics (1), i ricercatori dimostrano come il loro robot abbia utilizzato queste capacità per articolare parole in una varietà di lingue, e persino cantare una canzone tratta dal suo album di debutto generato dall’IA, “hello world”.

Il robot ha acquisito questa abilità attraverso l’apprendimento osservazionale anziché tramite regole. Ha prima imparato a usare i suoi 26 motori facciali osservando il proprio riflesso allo specchio, per poi imparare a imitare il movimento delle labbra umano guardando ore di video su YouTube.

«Più interagirà con gli esseri umani, meglio diventerà», ha promesso il dottor Hod Lipson (2), James and Sally Scapa Professor of Innovation nel Dipartimento di Ingegneria Meccanica e direttore del Creative Machines Lab della Columbia, dove è stato svolto il lavoro.

Il robot si osserva mentre parla

Raggiungere un movimento realistico delle labbra nei robot è difficile per due motivi: primo, richiede un hardware specializzato dotato di una pelle facciale flessibile azionata da numerosi minuscoli motori che possano lavorare rapidamente e silenziosamente in sincronia. Secondo, lo schema specifico della dinamica delle labbra è una funzione complessa dettata da sequenze di suoni vocali e fonemi.

I volti umani sono animati da dozzine di muscoli che si trovano appena sotto una pelle morbida e si sincronizzano naturalmente con le corde vocali e i movimenti delle labbra. Al contrario, i volti umanoidi sono perlopiù rigidi, operano con relativamente pochi gradi di movimento e il loro movimento labiale è coreografato secondo regole rigide e predefinite. Il risultato è un movimento impacciato, innaturale e inquietante.

In questo studio, i ricercatori hanno superato questi ostacoli sviluppando un volto flessibile e riccamente motorizzato, permettendo poi al robot di imparare a usarlo direttamente osservando gli esseri umani. Per prima cosa, hanno posizionato un volto robotico dotato di 26 motori davanti a uno specchio, così che il robot potesse imparare come il suo stesso viso si muove in risposta all’attività muscolare. Come un bambino che fa smorfie allo specchio per la prima volta, il robot ha eseguito migliaia di espressioni facciali e gesti labiali casuali. Col tempo, ha imparato a muovere i suoi motori per ottenere particolari configurazioni del viso, un approccio chiamato modello linguistico “vision-to-action” (VLA).

Poi, i ricercatori hanno posizionato il robot davanti a video registrati di esseri umani che parlavano e cantavano, dando all’IA che controlla il robot l’opportunità di imparare esattamente come si muovono le bocche umane in relazione ai vari suoni emessi. Con questi due modelli a disposizione, l’IA del robot poteva ora tradurre l’audio direttamente in azioni dei motori delle labbra.

I ricercatori hanno testato questa capacità utilizzando una varietà di suoni, lingue e contesti, oltre ad alcune canzoni. Senza alcuna conoscenza specifica del significato delle clip audio, il robot è riuscito a muovere le labbra in sincronia.

I ricercatori riconoscono che il movimento delle labbra è tutt’altro che perfetto. «Abbiamo avuto particolari difficoltà con suoni duri come la ‘B’ e con suoni che richiedono l’increspamento delle labbra, come la ‘W’. Ma queste capacità probabilmente miglioreranno con il tempo e la pratica», ha detto Lipson.

Ancora più importante, però, è considerare il lip sync come parte di una capacità comunicativa robotica più olistica.

Il dottor Yuhang Hu (3), che ha guidato lo studio, racconta: «Quando la capacità di sincronizzazione labiale viene combinata con un’IA conversazionale come ChatGPT o Gemini, l’effetto aggiunge una profondità completamente nuova alla connessione che il robot instaura con l’essere umano. Più il robot osserva gli esseri umani conversare, meglio diventerà nell’imitare quei gesti facciali sfumati con cui possiamo connetterci emotivamente e più lunga è la finestra contestuale della conversazione, più sensibili al contesto diventeranno questi gesti».

L’anello mancante delle capacità robotiche

I ricercatori ritengono che l’affettività facciale sia l’“anello mancante” della robotica.

Secondo il dottor Hod Lipson, «Gran parte della robotica umanoide oggi è focalizzata sul movimento delle gambe e delle mani, per attività come camminare e afferrare. Ma l’affettività facciale è altrettanto importante per qualsiasi applicazione robotica che coinvolga l’interazione umana».

Lipson e Hu prevedono che volti caldi e realistici diventeranno sempre più importanti man mano che i robot umanoidi troveranno applicazione in settori come l’intrattenimento, l’istruzione, la medicina e persino l’assistenza agli anziani. Alcuni economisti prevedono che oltre un miliardo di umanoidi sarà prodotto nel prossimo decennio.

«Non esiste un futuro in cui tutti questi robot umanoidi non abbiano un volto. E quando finalmente avranno un volto, dovranno muovere correttamente occhi e labbra, altrimenti rimarranno per sempre inquietanti», stima Lipson.

«Noi esseri umani siamo semplicemente fatti così, non possiamo farci nulla. Siamo vicini ad attraversare l'uncanny valley», ha aggiunto Hu.

Rischi e limiti

Questo lavoro fa parte della ricerca decennale di Lipson volta a trovare modi per far sì che i robot si connettano più efficacemente con gli esseri umani, attraverso la padronanza di gesti facciali come sorridere, guardare e parlare. Egli insiste sul fatto che queste capacità debbano essere acquisite tramite apprendimento, piuttosto che programmate con regole rigide.

«Accade qualcosa di magico quando un robot impara a sorridere o a parlare semplicemente osservando e ascoltando gli esseri umani», ha detto. «Sono un roboticista disincantato, ma non posso fare a meno di sorridere a un robot che mi sorride spontaneamente».

Il professor Hu ha spiegato che i volti umani sono l’interfaccia definitiva per la comunicazione, e stiamo iniziando a svelarne i segreti.

«I robot con questa attitudine avranno chiaramente una capacità molto migliore di connettersi con gli esseri umani, perché una parte così significativa della nostra comunicazione coinvolge il linguaggio corporeo facciale, e tutto questo canale è ancora inutilizzato», sostiene Hu.

I ricercatori sono consapevoli dei rischi e delle controversie legate al concedere ai robot una maggiore capacità di connettersi con gli esseri umani.

«Questa sarà una tecnologia potente. Dobbiamo procedere lentamente e con cautela, così da poter raccogliere i benefici minimizzando i rischi», ha concluso Lipson.

Aurori dello studio: Yuhang Hu, Jiong Lin, Judah Allen Goldfeder, Philippe M. Wyder, Yifeng Cao, Steven Tian, Yunzhe Wang, Jingran Wang, Mengmeng Wang, Jie Zeng, Cameron Mehlman, Yingke Wang, Delin Zeng, Boyuan Chen e Hod Lipson. Finanziatori: Lo studio è stato supportato dall'US National Science Foundation (NSF) AI Institute for Dynamical Systems (DynamicsAI.org) e da una elergizione dell'Amazon to Columbia AI institute.

Riferimenti:

(1) Learning realistic lip motions for humanoid face robots

(2) Hod Lipson

(3) Yuhang Hu

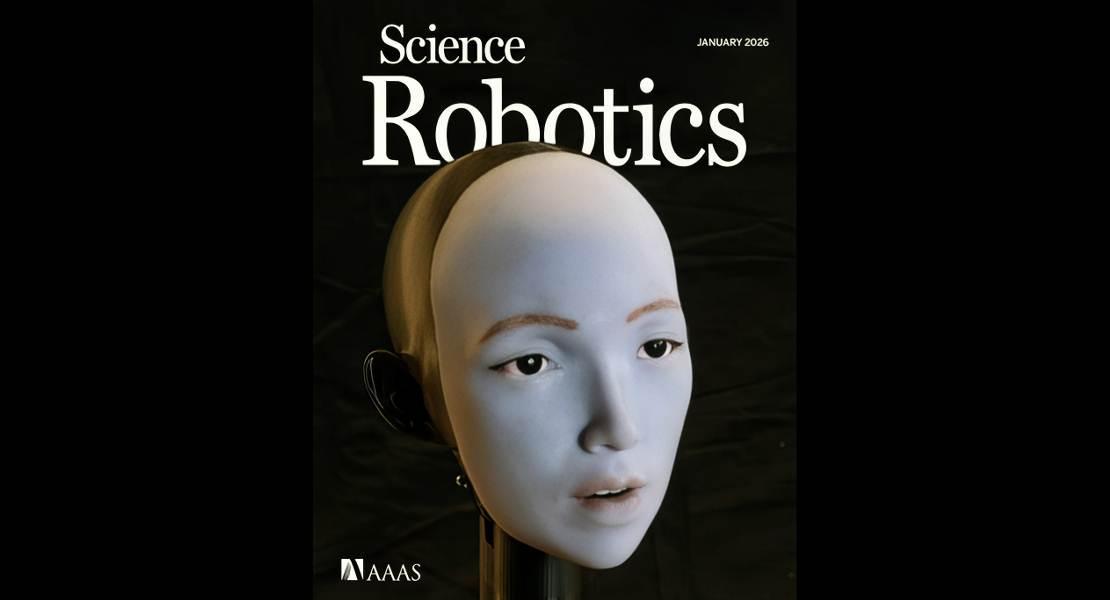

Descrizione foto: Presentato sulla copertina di Science Robotics, Hod Lipson e il suo team hanno creato un robot che, per la prima volta, è in grado di apprendere i movimenti delle labbra facciali per compiti come parlare e cantare. - Credit: Jane Nisselson/ Columbia Engineering.

Autore traduzione riassuntiva e adattamento linguistico: Edoardo Capuano / Articolo originale: A Robot Learns to Lip Sync